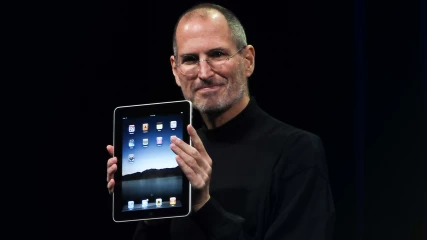

Ερευνητές δημιούργησαν ένα CSAM σύστημα σαν της Apple και κατέληξαν πως είναι επικίνδυνο

Η Apple έχει ξεσηκώσει αντιδράσεις για τη νέα της τεχνολογία CSAM (child sexual abuse material), με την εταιρία από τη μία να δηλώνει πως είναι ασφαλές για τους χρήστες και από την άλλη τους επικριτές να φοβούνται πως αυτό θα σημάνει το τέλος της ιδιωτικότητας. Πέρα όμως από υποθετικές δηλώσεις, τώρα έχουμε και την άποψη των ακαδημαϊκών. Δύο ερευνητές του Princeton University, αποκάλυψαν πως μετά από χρόνια ανάπτυξης ενός συστήματος σχεδόν ίδιου με της Apple, κατέληξαν πως μπορεί κάποιος εύκολα να καταχραστεί τις δυνατότητές του.

Γράψαμε τη μόνη peer-reviewed δημοσίευση για το πώς να δημιουργήσεις ένα σύστημα σαν της Apple. Και καταλήξαμε πως η τεχνολογία αυτή είναι επικίνδυνη. – Jonathan Mayer

Οι δύο ερευνητές ανέπτυξαν ένα σύστημα αναγνώρισης CSAM με end-to-end κρυπτογράφηση για online υπηρεσίες. Όπως και η Apple έτσι και αυτοί, ήθελαν ένα τρόπο να περιορίσουν τον πολλαπλασιασμό των CSAM ενώ ταυτόχρονα να διατηρήσουν την ιδιωτικότητα του χρήστη. Μετά από δύο χρόνια ανάπτυξης, είχαν στα χέρια τους ένα λειτουργικό πρωτότυπο.

Τότε διαπίστωσαν πως υπήρχε ένα σημαντικό πρόβλημα με την τεχνολογία τους.

Το σύστημά μας μπορούσε εύκολα να αναδιαμορφωθεί για παρακολούθηση και λογοκρισία. Το design δεν περιοριζόταν σε μία συγκεκριμένη κατηγορία περιεχομένου. Η υπηρεσία μπορεί απλά να αλλάξει σε οποιαδήποτε database επιθυμεί και ο χρήστης δε θα γνώριζε τίποτα.

Οι ερευνητές μάλιστα δε μιλούν απλά για υποθετικά σενάρια, αφού έφεραν ως παράδειγμα το κινεζικό WeChat, στο οποίο βρέθηκαν αλγόριθμοι που ανιχνεύουν υλικό αντιφρονούντων.

Η Κίνα είναι η δεύτερη μεγαλύτερη αγορά της Apple με εκατοντάδες εκατομμύρια συσκευές. Τι σταματά την κινεζική κυβέρνηση από το να απαιτήσει από την Apple να σκανάρει όλες αυτές τις συσκευές για υλικό υπέρ της δημοκρατίας; Εντοπίσαμε και άλλα προβλήματα. Η διαδικασία σύγκρισης των εικόνων μπορεί να δώσει ψευδώς θετικά αποτελέσματα και κακόβουλοι χρήστες μπορούν να ξεγελάσουν το σύστημα για να υποβάλλουν αθώους χρήστες σε έλεγχο.

Οι ερευνητές τόνισαν πως σκόπευαν να συζητήσουν τα ευρήματά τους σε ένα ακαδημαϊκό συνέδριο, αλλά δεν πρόλαβαν επειδή η Apple ανακοίνωσε την τεχνολογία αυτή μία εβδομάδα πριν την παρουσίαση.

Το κίνητρο της Apple, όπως και το δικό μας, ήταν να προστατέψουμε τα παιδιά. Και το σύστημά τους ήταν τεχνικά πιο αποδοτικό και ικανό από το δικό μας. Αλλά μας εξέπληξε το γεγονός πως η Apple είχε πολύ λίγες απαντήσεις για τα σκληρά ερωτήματα που ήρθαν στο φως της δημοσιότητας.

Όλο το paper της έρευνας μπορείτε να το βρείτε εδώ.

Ακολουθήστε το Unboxholics.com στο Google News για να μαθαίνετε πρώτοι τα τελευταία νέα για τεχνολογία, videogames, ταινίες και σειρές. Ακολουθήστε το Unboxholics.com σε Facebook, Twitter, Instagram, Spotify και TikTok.