Τρομακτική AI της Microsoft μπορεί να φτιάξει deep fakes με μια μόνο φωτογραφία

Από τις αρχές του περασμένου έτους που το ChatGPT έκανε το εκρηκτικό του ντεμπούτο αλλάζοντας μια για πάντα το διαδίκτυο, κάθε λίγες μέρες ανακοινώνεται και μια νέα σημαντική εξέλιξη από τον κλάδο της τεχνητής νοημοσύνης. Κάπως έτσι, το τμήμα Microsoft Research του Αμερικανού tech κολοσσού ήρθε τώρα να πάρει τη σκυτάλη και να σοκάρει τα social media με το VASA-1 μοντέλο.

Τι είναι το VASA-1; Τα αρχικά σημαίνουν Visual Affective Skills Audio και πρόκειται για ένα artificial intelligence framework που φιλοδοξεί να αλλάξει τις ψηφιακές επικοινωνίες. Τι μπορεί να κάνει; Η εξαιρετικά προηγμένη τεχνητή νοημοσύνη παράγει απίστευτα ρεαλιστικά deep fake βίντεο, για τα οποία χρειάζεται μόνο μια φωτογραφία ενός ανθρώπου και μια μόνο σύντομη ηχογράφηση της φωνής του.

Τα αποτελέσματα είναι τόσο πιστευτά που σχεδόν περνιούνται για πραγματικά βίντεο και προφανώς…τρομάζουν. Η ικανότητα του μοντέλου να μιμείται τις φυσικές κινήσεις του κεφαλιού και ένα ευρύ φάσμα συναισθημάτων είναι απαράμιλλη και σηματοδοτεί ένα πολύ σημαντικό άλμα προς τα εμπρός όσον αφορά το animation με τεχνητή νοημοσύνη.

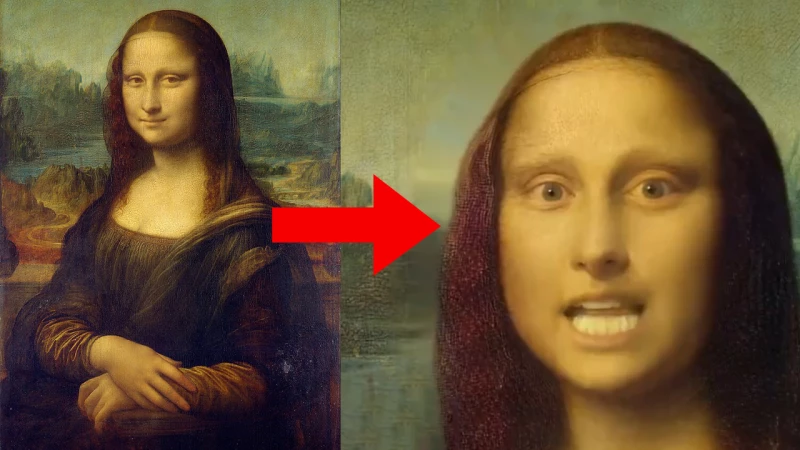

Η τεχνολογία μπορεί μελλοντικά να φέρει τα πάνω κάτω όχι μόνο στις επικοινωνίες, αλλά και σε βιομηχανίες όπως το gaming και ο κινηματογράφος. Τα social media ήδη έχουν σοκαριστεί με τις δυνατότητές του VASA-1, το οποίο πέρα από φωτογραφίες πραγματικών ανθρώπων, μπορεί να ζωντανέψει μέχρι και πίνακες.

Είναι από τις περιπτώσεις που τα πολλά λόγια περισσεύουν, οπότε σας αφήνουμε να παρακολουθήσετε μερικά από τα παραδείγματα χρήσης του μοντέλου που δόθηκαν στα φώτα της δημοσιότητας, παρουσιάζοντας τις προηγμένες του δυνατότητες. Το αποκορύφωμα είναι η Mona Lisa να…ραπάρει:

Microsoft just dropped VASA-1.

— Min Choi (@minchoi) April 18, 2024

This AI can make single image sing and talk from audio reference expressively. Similar to EMO from Alibaba

10 wild examples:

1. Mona Lisa rapping Paparazzi pic.twitter.com/LSGF3mMVnD

Ο ρεαλισμός και η ζωντάνια του VASA-1 μοντέλου:

2. Realism and liveliness - example 1 pic.twitter.com/Kz0Bm2NRNy

— Min Choi (@minchoi) April 18, 2024

3. Realism and liveliness - example 2 pic.twitter.com/7nVrTtDUmM

— Min Choi (@minchoi) April 18, 2024

Τα διαφορετικά συναισθήματα που μπορεί να αποδώσει στη φωτογραφία το μοντέλο:΅

6. Controllability of generation 2

— Min Choi (@minchoi) April 18, 2024

Example of different emotion offsets pic.twitter.com/vusoSAPgb4

Τα ίδια αποτελέσματα με διαφορετική φωτογραφία ως πηγή:

7. Power of disentanglement

— Min Choi (@minchoi) April 18, 2024

Example of same motion sequence with different photos pic.twitter.com/MSLFobwJTx

Ακολουθήστε το Unboxholics.com στο Google News για να μαθαίνετε πρώτοι τα τελευταία νέα για τεχνολογία, videogames, ταινίες και σειρές. Ακολουθήστε το Unboxholics.com σε Facebook, Twitter, Instagram, Spotify και TikTok.